本报记者 秦枭 北京报道

随着人工智能技术的飞速发展,特别是大型AI模型的广泛应用,不仅带动了GPU行业的蓬勃发展,同时带动了高性能存储器的需求呈现出不断增长的态势。国泰君安发布的研究报告称,高带宽存储器(HBM)的年需求增长率预计将高达40%。

面对这一市场趋势,国内外众多企业已纷纷加大投资力度,以应对市场的变化。HBM技术通过先进的封装工艺,实现了多个DRAM(动态随机存取存储器)的垂直堆叠,为高性能AI算力提供了高效、稳定、低延迟和低功耗的存储解决方案。

多位业内人士在接受《中国经营报》记者采访时表示,HBM技术确实展现出了显著的高速、高带宽和低功耗特性,这使得它在当前AI市场的热潮中具有广泛的应用前景,特别是在高性能计算和人工智能领域。然而,任何技术都不是完美的,HBM同样存在一些劣势,HBM的容量相对较小、延迟时间较长,且在系统搭配方面缺乏一定的灵活性。尽管如此,在实际应用中,仍可以通过混合搭配不同的产品来弥补这些不足,从而充分发挥HBM技术的优势,满足特定功能需求。

三分天下

自2022年11月OpenAI推出ChatGPT以来,AI大规模应用的时代正式拉开序幕。各大科技公司纷纷投入研发,推出大型AI模型产品。这些大型模型的训练与部署,对AI算力芯片的需求激增,同时,对于数据存储与传输的要求也显著提高。据美光公司测算,相较于传统服务器,AI服务器中的DRAM需求量提升了8倍,而NAND(计算机闪存设备)存储器的需求也增长了3倍。这一趋势无疑推动了存储芯片市场的快速增长。

华策战略咨询创始人詹军豪表示,HBM通过将多个DRAM 芯片堆叠在一起,并使用高速接口进行连接,提供了更高的带宽和更低的延迟,这对于人工智能、机器学习、高性能计算等领域非常重要。

“AI大模型是经由一种基于数据大爆炸模式的AI训练与推理流程所诞生,这一流程可能涵盖数以万亿计的参数,并极度依赖专注于高性能领域的HBM存储系统。”半导体分析师王志伟对记者表示,“以GPT-3模型为例,其参数量已达到惊人的1750亿,而最新推出的GPT-4模型更是将参数量提升至1.76万亿的庞大规模。为了突破限制,我们必须解决内存墙和功耗墙的瓶颈。由于数据交换通路的狭窄,带来了制约数据处理速度的内存墙,以及大量数据传输的高能耗的功耗墙问题。”

在面对AI大模型的千亿乃至万亿级别的参数时,服务器中的计算核心GPU几乎必须搭载HBM。AI服务器GPU市场以NVIDIA H100、A100、A800以及AMD MI250、MI250X系列为主,基本都配备了HBM。

中国民营科技实业家协会元宇宙委员会秘书长吴高斌表示,相比传统的存储,HBM的优势主要体现在更高的带宽和更低的延迟。HBM通过堆叠多个DRAM芯片,形成了高度集成的模块,可以在更小的空间内提供更大的容量和更高的带宽。此外,HBM的电压和电流也低于传统存储,从而降低了能耗。

英伟达联合创始人兼首席执行官黄仁勋表示:“HBM是一个技术奇迹。”他补充说,HBM还可以提高能源效率,并且随着耗电的人工智能芯片变得更加普遍,可以帮助世界变得更加可持续。

据中信建投测算,以8张80GB的NVIDIA A100/H100计算,需要的HBM用量约为640GB,已超越了常规服务器的内存条容量,H200、B100等算力卡将搭载更高容量、更高速率HBM。“我们测算,随着算力卡单卡HBM容量提升、算力卡出货量提升、技术迭代带来单GB HBM单价提升,2023年HBM市场规模为40亿美元,预计2024年将增长至148亿美元,2026年增长至242亿美元,2023~2026年CAGR(复合年均增长率)为82%。”中信建投称。

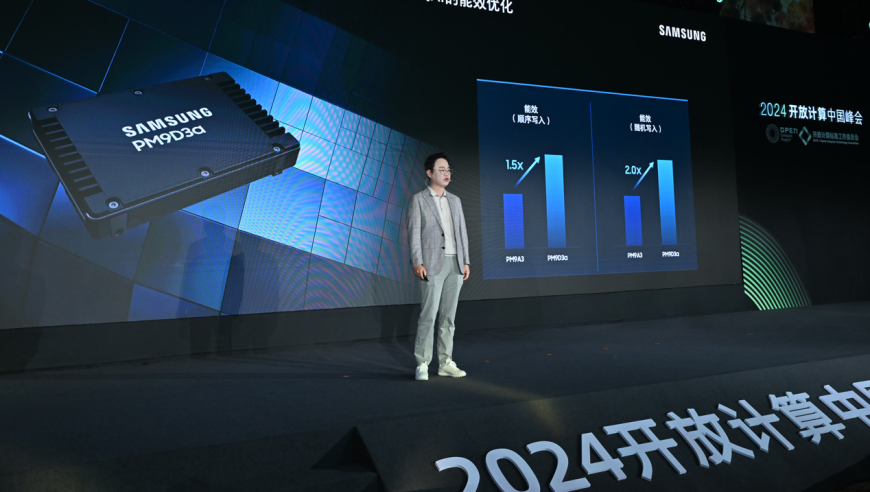

随着市场规模的持续扩张,各大厂商纷纷投身于HBM的激烈竞争中。作为全球领先的两大存储器芯片制造商,三星与SK海力士已明确表态,将显著增加HBM的生产规模,以满足市场迫切的需求。值得一提的是,SK海力士已经顺利启动高带宽内存产品HBM3E的量产,并稳步向客户供应。与此同时,全球第三大DRAM公司美光科技亦宣告,自2024年起将正式涉足HBM市场。

不过,就目前而言,全球HBM市场被海外存储大厂所“垄断”,并呈现“三分天下”的局面,存储芯片三巨头SK海力士、三星和美光分别占到53%、38%和9%的市场份额,而SK海力士则是唯一具备量产新世代HBM3能力的供应商。

TrendForce集邦咨询指出,以HBM产能来看,三星、SK海力士至今年年底的HBM产能规划最积极,三星HBM总产能至年底将达约130K(含TSV);SK海力士约120K,但产能会依据验证进度与客户订单持续而有变化。另以现阶段主流产品HBM3产品市占率来看,目前SK海力士的市场比重逾9成,而三星将随着后续数个季度AMD MI300逐季放量持续紧追。

看客还是玩家?

海外HBM竞争如火如荼,国内的存储厂商也蠢蠢欲动。据报道,国内存储厂商武汉新芯(XMC)已经启动了专注开发和制造的 HBM 项目,瞄准了人工智能和高性能计算(HPC)领域。长鑫存储(CXMT)也计划生产 HBM 内存,已经获得用于 HBM 存储器组装和测试的装置。

不过,中信建投研报指出,国产HBM正处于0到1的突破期,HBM供应主要为韩系、美系厂商,国内能获得的HBM资源较少。随着国产算力卡需求快速增长,对于算力卡性能至关重要的HBM也有强烈的供应保障诉求和国产化诉求,封测、设备、材料等环节值得关注。

此前,通富微电(002156.SZ)表示,南通通富工厂先进封装生产线建成后,公司将成为国内最先进的2.5D/3D先进封装研发及量产基地,实现国内在HBM高性能封装技术领域的突破,对于国家在集成电路封测领域突破“卡脖子”技术具有重要意义。

国内封测龙头长电科技(600584.SH)也曾在投资者互动中表示,其XDFOI高密度扇出封装解决方案也同样适用于HBM的Chip to Wafer 和Chip to Chip TSV堆叠应用。

詹军豪表示,在HBM的上下游中,中国企业可以选择成为玩家而不仅仅是看客。虽然HBM技术目前主要由国外企业主导,但中国企业仍可以通过加强研发投入、技术创新和产业合作,在这个领域获得更多的话语权和市场份额。这需要中国企业在芯片设计、制造工艺、封装技术等方面进行突破,并与国内外相关企业合作,共同推动HBM技术的发展。

天使投资人、人工智能专家郭涛则指出,对于中国的企业来说,既有机会也有挑战。一方面,中国在AI和高性能计算领域有着强大的需求,这为HBM的发展提供了广阔的市场。另一方面,中国企业在HBM的研发和生产方面还存在一定的差距,需要加大投入和努力。因此,中国企业既可以作为玩家参与HBM的研发和生产,也可以作为看客观察和学习HBM的发展。

然而,尽管HBM市场前景广阔,但目前仍面临一些挑战。首先,HBM技术的生产成本较高,这在一定程度上限制了其在大规模商业应用中的普及,根据市场研究公司 Yole Group 2月8日的数据,今年 HBM 芯片的平均售价是传统 DRAM 内存芯片的5倍。其次,HBM的封装和集成技术也面临一定的难题,需要产业链上下游企业共同协作,才能推动技术的成熟和普及。

(:张靖超 :刘军)

随着AI技术的飞速发展,尤其是大型AI模型的广泛应用,不仅带动了GPU行业的蓬勃发展,同时带动了高性能存储器的需求呈现出不断增长的态势。HBM技术作为高速、高带宽和低功耗存储解决方案,被认为在未来的大数据分析、人工智能、机器学习等领域具有广泛的应用前景。

HBM技术的最大优势在于通过将多个DRAM芯片堆叠在一起,实现了多个DRAM的垂直堆叠,从而提高了存储器的速度和容量。然而,由于各种原因,HBM在实际应用中并未完全发挥其优势,仍需通过混合搭配不同的产品来弥补这些不足,以满足特定功能需求。

从市场趋势来看,AI大规模应用的时代正式拉开序幕,各大科技公司纷纷加大研发投入,推出大型AI模型产品。HBM因其高速、高带宽和低功耗特性,有望在这场浪潮中占据重要地位。

尽管面临一些挑战,例如高昂的成本、封装和集成的技术难题等,但随着技术和市场需求的变化,HBM技术仍有很大的发展空间。未来,中国企业的积极参与将有助于推动HBM技术在中国乃至全球市场的普及和发展。同时,中国的科技创新和产业合作也将有力地推动HBM技术的创新和发展。